Cyberhotnivån ökar när nätfiske-som-tjänst fördubblas

Kriminella grupperingar fortsätter att utöka sitt samarbete inom området för cyberkriminalitet, vilket höjer den generella cyberhotsnivån för företag av alla storlekar!

Med en starkt växande marknad av cyberattack-som-tjänst, där en nyligen publicerad rapport speciellt lyfter fram nätfiske-som-tjänst (Phishing-as-a-Service (PhaaS)), växer antalet hotaktörer snabbt, då även ligor med låg teknisk kompetens inte bara kan utföra avancerade cyberattacker, de kan dessutom göra det på stor skala.

Avancerade cyberattacker körs med otrolig små resurser

Kriminella samarbeten ökar

Kriminella organisationer är opportunister och när en möjlighet öppnas är de ofta snabba på att utnyttja den. Således är det föga överraskande att en globaliserad digital värld också leder till att även cyberhotbilden globaliseras.

Hotkomplexiteten ökar ständigt och både kriminella samarbeten och användning av AI driver på utvecklingen. Dessutom innebär tillgängligheten av cyberbrottstjänster, som är en är enorm och växande marknad, såsom Phishing-as-a-Service (PhaaS), att även ligor med låg teknisk kompetens kan utföra storskaliga och mycket avancerade nätfiskeattacker.

Mer avancerad cyberbrottslighet kräver mer avancerat cyberförsvar

Nätfisketjänster fördubblades under 2025

Nätfisketjänster som utvecklas och tillhandahålles av ytterst tekniskt kompetenta aktörer ökar inte bara till antalet, med en fördubbling under 2025, de blir dessutom mer sofistikerade och skalbara.

Nätfisketjänsterna är utformade för att göra det svårare för användare och säkerhetsteam att upptäcka och förhindra dem. De vanliga tillvägagångssätten känns igen, vilka är att lura användare genom social manipulation att klicka på länkar, skanna QR-koder, öppna bilagor eller dela personlig information

Dessa tillvägagångssätt är fortfarande framgångsrika trots åratal av säkerhetskontroller och insatser för att öka användarmedvetenheten. Angripare använder dessutom i allt högre grad AI och nya metoder för att undvika upptäckt.

Mer avancerad cyberbrottslighet kräver mer avancerat cyberförsvar

Hör av dig om du vill ha tips på hur ni kan minska risken för cyberintrång!

Vi kan hjälpa er med allt ifrån att identifiera era sårbarheter, en tydligt prioriterad åtgärdsplan till att övervaka era system dygnet runt och omedelbart hantera de cyberattacker och intrångsförsök ni utsätts för.

Explosionsartad ökning av AI-relaterade cyberhot

Utvecklingen går i en rasande fart och AI står i centrum för väldigt många av de banbrytande utvecklingsprojekt som snart alla företag investerar i. Med ett stort fokus på AIs potential syns även en tydlig trend att ett ökat antal företag börjar bli smärtsamt medvetna om att de inte är förberedda för att hantera riskerna kopplade till AI.

Det är av största vikt att börja väga AIs potential och fördelar mot de risker som blir alltmer uppenbara. Fler behöver förstå att AI är som ett tveeggat svärd - både är den största möjligheten och det största hotet i modern tid.

Föga förvånande är det således att över 50 % av de tillfrågade cybersäkerhetspecialisterna, i en nyligen publicerad rapport, uppgav att de förväntar sig att AI-drivna cyberattacker kommer att vara ett verkligt stort problem under 2026. Företagens osäkerhet på sin egen förmåga att hantera både sin egen AI och AI-drivna cyberattacker, gör att denna oro bara växer.

På frågan om det mest framstående hotet kopplat till AI så svarade ungefär sex av tio att AI-driven social manipulation och deepfakes är det största hotet.

AI, ett tveeggat svärd - den största möjligheten och det största hotet

Svenska företag inte heller förberedda

Om man ser på beredskap hos svenska företag så säger en annan studie att bara ett av tre svenska företag har en god kunskap om AI-relaterade cybersäkerhetshot. Därtill svarade över 80% i denna undersökning att de förväntar sig att uppleva cyberattacker och incidenter relaterade till AI i närtid

AI + människa = sant

Med ett ökat hot drivet av AI, som gör hotbilden mer och mer avancerad och komplicerad, krävs det även att man använder AI i sitt cyberförsvar. AI kan hjälpa cybersäkerhetsspecialister med att analysera enorma mängder data och information, samt även stötta på annat sätt. Alla människor i organisationen är dock vitala för den övergripande motståndskraften.

Givetvis är cybersäkerhetsspecialisterna en uppenbart central del men även personalen i övrigt har en viktig roll att spela. Alla medarbetare är en del av försvarslinjen och det är viktigt att fostra både en stark medvetenhet och en säkerhetskultur i organisationen. Utbildning är det grundläggande elementet i att bygga personalens medvetenhet om AI-relaterade hot, men också att de får genomgå simuleringar med avancerat nätfiske och deepfake, då detta ökar deras möjlighet att bidra till företagets motståndskraft.

AI krävs också för ett starkt cyberförsvar

Vi inkluderar AI i ditt cyberförsvar!

Vi på Addera erbjuder avancerade övervakningstjänster och incidentberedskap, veckans alla dagar och dygnets alla timmar. Naturligtvis är AI en integrerad del av dessa tjänster och mervärdet är väldigt tydliga:

- upptäcker cyberattacker i tid

- stoppar attackerna innan de orsakar skada

- minskar möjligheten för cyberbrottslingar att skada/störa er er verksamhet

Våra övervaknings- & incidentberedskapstjänster, med konstant övervakning och beredskap, närapå en förutsättning för att kunna stå emot när AI-relaterade cyberattacker ständigt blir fler, större och mer sofistikerade. Vår tjänst inkluderar toppmoderna AI-verktyg, som snart är det enda motmedlet mot den avancerade AI som cyberbrottslingarna använder i allt större utsträckning.

Hör av dig om du också vill ha större cybertrygghet – varje dag, året runt och på alla dygnets timmar.

Cyberhotet är största risken - både nu och i framtiden

Det finns många risker och hot i vår värld men föga förvånande så är cyberhot och cyberrisker rankat som nummer 1 i en nyligen publicerad rapport. Det är dessutom tredje året i rad som cyberhotet rankas högst. Inte bara är cyberhotet den högsta risken just nu, det rankas också som den största risken i framtiden.

Undersökningen visar hur riskerna både förändras och ökar, både i intensitet och i komplexitet. Rapporten menar också att de olika riskområdena, som rankas som de största, dessutom påverkar och förstärker varandra i större och större utsträckning. Man kan tänka sig att på en av de topprankade riskområdena, den geopolitiska arenan, finns nationer som använder cyberhot och cyberattacker som verktyg för att skapa instabilitet, vilket i så fall skulle få en direkt och tydlig koppling till det förstärkta cyberhotet.

Cyberhotet, den högsta risken just nu och den största risken i framtiden.

Cyberhotets delar

Hotlandskapet förändras ständigt och det finns flera olika faktorer som påverkar det ökade cyberhotet utifrån. Geopolitik och med illasinnade nationer, som driver cyberhotet, nämnde vi ovan, men det finns fler aspekter. Fler hotaktörer, en globaliseringstrend där cyberbrottssyndikat verkar och samarbetar över nationsgränserna och alltmer sofistikerade attackmetoder drivna av bla AI.

Risker med digitalisering och AI

Men det finns även interna faktorer som ökar risknivån och sårbarheterna.

Digitalisering är fortsatt ett viktigt utvecklingsområde och många företag gör dessutom allt för att hänga på AI-tåget och känna att de drar nytta av ny teknik. Tyvärr negligeras säkerheten alltför ofta och man implementerar AI-verktyg och lösningar som man inte helt förstår riskerna med. Uppgifter säger att så mycket som 75% av nuvarande användning av AI kan anses osäker och innebär således en tydligt ökad risk.

Därtill används AI av brottslingar till att utveckla, skala upp och automatisera cyberattackerna. Här säger rapporter att den årliga ökningen av tex social manipulation, kopplat till AI, är 50%.

Fler hotaktörer, globala kriminella samarbeten och alltmer sofistikerade attackmetoder

Cybersäkerhet en strategisk fråga

Länge har vi på Addera argumenterat för att företagets motståndskraft mot det ökade cyberhotet måste föras upp på agendan som en strategiskt prioriterad fråga, och att frågan således hör hemma på lednings- och styrelsenivå. Överallt hör vi nu samma argument från de allra största spelarna inom cybersäkerhet och man kan fråga sig när våra företagsledare ska vakna?

Ingen ifrågasätter det faktum att cyberhotet växer, både i omfattning och i komplexitet. Lägger vi dessutom till de sårbarheter som företagen själva skapar, genom en ibland slarvig, förhastad och okontrollerad digitalisering och användning av AI, så blir det tydligt att verksamheter också själv bidrar till att öka sin egen sårbarhet.

Därför är det största vikt att företagsledning och till och med styrelse skapar sig en förståelse för hur digitaliseringens fördelar också ökar företagets riskexponering. Ledningen måste äga hela frågan och föra upp cybersäkerheten, vilket egentligen handlar om affärskontinuitet och överlevnad, på den strategiska agendan och behandla området, som en del av företagets absolut viktigaste frågor.

När ledningen sätter tonen för cybersäkerhetsarbetet finns möjligheter att snabbt skapa en positiv attitydförändring i organisationen. Detta är en avgörande faktor för att bygga en motståndskraftig cybersäkerhetskultur då det skapar engagemang som gör personalen till en del av företagets försvarsberedskap.

Hur kan vi hjälpa er företagsledning med att ta nästa steg?

Majoriteten av cyberattackerna sker på nätter och helger

I en nyligen publicerad säkerhetsrapport framgår det som tidigare indikerats, nämligen att en väldigt stor andel av cyberattacker sker utanför kontorstid, när många IT-avdelningar och cybersäkerhetsexperter är lediga.

Allt fler organisationer ropar efter hjälp för att hantera den ökande mängd cyberattacker som sker utanför kontorstid. Det finns nämligen ett tydligt samband mellan när säkerhetspersonalen inte är på plats och ökning av cyberattacker. Många mindre företag har dessutom inga jourfunktioner och då händelseförloppet typiskt är snabbt riskerar skadorna att bli enorma när en attack inte stoppas eller hanteras omedelbart.

På måndagsmorgonen är det förmodligen redan kört!

Konstant övervakning med incidentberedskap 24/7 är svaret

När en attack sker kl 03 en söndag, vem hjälper er då?

Vi på Addera erbjuder övervakningstjänster och incidentberedskap, veckans alla dagar och dygnets alla timmar.

Mervärdet denna tjänst är väldigt lätta att förstå:

- upptäcker cyberattacker i tid

- stoppar attackerna innan de orsakar skada

- minskar möjligheten för cyberbrottslingar att skada/störa er er verksamhet

För mindre företag, utan egen cybersäkerhetspersonal så är våra övervaknings- & incidentberedskapstjänster, med konstant övervakning och beredskap, närapå en förutsättning för att kunna stå emot när cyberattackerna ständigt blir fler, större och mer sofistikerade. Vår tjänst inkluderar toppmoderna AI-verktyg, som snart är det enda motmedlet mot den avancerade AI som cyberbrottslingarna använder i allt större utsträckning.

För större verksamheter är övervaknings- & incidentberedskapstjänsterna ett sätt att skaffa sig kontroll och beredskap. Det är en enorm trygghet och stöd för er egen säkerhetspersonal så de vet att beredskap och cybersäkerhet är på topp, även när de är lediga.

Hör av dig om du också vill ha större cybertrygghet – varje dag, året runt och på alla dygnets timmar.

Oktober: Cyber Security Month

Vi på Addera vill göra allt vi kan för att bidra till en ökad cybersäkerhet i Sverige.

Vårt syfte är att hjälpa företag med cybersäkerheten. Vi gör det för att trygga verksamhet, arbetstillfällen och konkurrenskraft eftersom cyberbrottsligheten är ett verkligt hot mot Sverige och det svenska näringslivet. Med en säkrare och tryggare verksamhet har våra kunder möjlighet att fokusera på sin kärnverksamhet och bedriva denna utan kostsamma avbrott i verksamheten pga cyberbrottslighet.

Vi vill dessutom bidra till att sprida viktig information om cyberhotet och dela värdefull information. Kunskap och medvetenhet är nämligen en viktig aspekt av cybersäkerhetsarbetet och vi ser alltför många företag som sticker huvudet i sanden. Därför delar vi nedan med oss av utvald information från MSB och den EU-gemensamma sidan EuropeanCyberSecurityMonth (kursivt).

Låt cybersäkerhetsmånaden vara den inspiration som behövs för att sätta igång!

Informationssäkerhetsmånaden

Kampanjen är ett långsiktigt arbete med målsättningen att höja medvetenheten och kompetensen hos privatpersoner och företagen för att säkrare hantera exempelvis lösenord, e-legitimation och sin viktigaste information.

Digitaliseringen ökar snabbt och påverkar i hög grad enskilda individer och samhället som helhet. Det gör att det är nödvändigt att lägstanivån på samhällets informations- och cybersäkerhet höjs. Kampanjen är ett led i detta.

Kampanjen genomförs av MSB tillsammans med polisen. Därutöver har ett stort antal samarbetspartners från privat, offentlig och ideell verksamhet engagerats för att sprida kampanjens budskap.

Oktober är EU:s informationssäkerhetsmånad (European Cyber Security Month - ECSM) och arrangeras av EU:s byrå för nät- och informationssäkerhet (Enisa). Syftet är att öka medvetenhet om informations- och cybersäkerhetsfrågor hos allmänheten och hos företag. EU:s informationssäkerhetsmånad har funnits sedan 2012 och Sverige har deltagit genom MSB i ett antal år.

Kampanjen är ett långsiktigt arbete med målsättningen att höja medvetenheten och kompetensen

Cybersäkerheten, ett strategiskt område

Även om cyberhotet ständigt är på tapeten så är det likafullt angeläget att ytterligare belysa frågan, exemplifierat av Cybersäkerhetsmånaden. Vi behöver poängtera vikten av ett aktivt ägandeskap från företagsledningen eftersom cybersäkerheten måste vara en naturlig del av organisationers strategiska arbete.

När ledningen sätter tonen för säkerhetskulturen finns stora möjligheter att skapa en positiv attitydförändring i hela organisationen. Detta är en avgörande faktor för att bygga en motståndskraftig cybersäkerhetskultur då det skapar engagemang och gör personalen till en del av företagets försvarsberedskap.

Praktiska tips från EuropeanCyberSecurityMonth:

Var smartare än en hackare

- Prata inte med främlingar.

- Kom ihåg vad du lärt dig sedan barnsben, undvik att prata med någon du inte känner i verkliga livet eller inte har haft kontakt med på länge.

- Var försiktig med oväntade förfrågningar om din information.

- Din bank kommer aldrig att fråga efter dina lösenord. Följ inte instruktioner eller förfrågningar som avslöjar någon typ av personlig information

- Ingen ger bort något gratis i livet

- Detsamma gäller online. För-bra-för-att-vara-sant erbjudanden är precis vad det låter som, de är inte äkta!

- Var uppmärksam när du uppmanas att agera snabbt och under tidspress

- Ta ett djupt andetag och tänk efter innan du vidtar någon åtgärd.

- Det är alltid bättre att vara försiktig

- Om något verkar misstänkt eller för bra för att vara sant, ta dig tid att undersöka det innan du vidtar någon åtgärd

- Dela inte personlig information

- Till exempel lösenord, kreditkortsnummer eller identifieringsuppgifter. Håll dina personuppgifter säkra eftersom de är mycket värdefulla.

- Innan du klickar på en länk, verifiera alltid dess äkthet

- Det finns flera tecken som kan indikera en misstänkt länk, till exempel dåligt skrivna webbadresser eller okända domäner.

- Cyberkriminella poserar som personer eller organisationer du tror att du känner

- Använd alltid starka lösenord och aktivera tvåfaktors- eller multifaktorautentisering.

- Om du någonsin faller i fällan av cyberkriminella, gör det svårt för dem

- Ha alltid säkerhetskopior av din viktiga information, använd starka lösenord och håll alla dina enheter uppdaterade.

- Kunskap är ett kraftfullt verktyg i kampen mot cyberbrottslingar

- Dela dessa cybersäkerhetstips med dina nära och kära.

Medvetenhet om varningsflaggor

Var medveten om dessa varningsflaggor att undvika bedrägerier från cyberbrottslingar!

Ju fler du identifierar desto troligare är kommunikationen falsk.

- Oväntade förfrågningar

- Otroliga erbjudanden

- Brådskande

Ransomware

Cybersäkerhetstips som gör att du kan stoppa en pågående attack med tex ransomware.

- Använd aldrig okända USB-minnen.

- Om du inte vet var de kom ifrån, anslut inte till din dator.

- Klicka aldrig på okända länkar.

- Dubbelkolla alltid webbadressen för avvikelser innan du klickar på länkar i skräppostmeddelanden eller på okända webbplatser.

- Öppna aldrig misstänkta e-postbilagor.

- Lita inte på ett e-postmeddelande med information du aldrig har bett om.

- Var extra försiktig innan du öppnar oväntade mail.

- Kontrollera alltid avsändarens riktiga adress, samt eventuella bilagor eller hyperlänkar.

- Utför uppdateringar.

- Så snart du uppmanas. På din bärbara dator, eller när din IT-avdelning säger till.

- Använd virusskydd på alla dina enheter.

- Installera en som inkluderar ransomware-varningar och håll dem uppdaterade.

- Följ din organisations policy angående säkerhetskopiering.

- Det är avgörande att du alltid har säkerhetskopior av dina filer, helst i molnet och på en extern hårddisk.

- Få tillgång till ditt konto på ett säkert sätt.

- Använd alltid starka lösenord och aktivera tvåfaktors- eller multifaktorautentisering.

Nätfiske

Ett samtal, ett sms eller e-post kan vara en bluff. Värdefulla tips om hur du identifierar nätfiske.

- Leta efter dålig grammatik och oprofessionellt språk.

- Kom ihåg att cyberbrottslingar pressar dig att agera skyndsamt.

- Leta efter länkar till sajter med skadlig programvara. Klicka aldrig på dem!

- Lita inte på webbadressen du ser!

- Kontrollera hälsningen: de använder aldrig ditt för- och efternamn. Meddelandet är vanligtvis adresserat till en generisk mottagare.

- Håll utkik efter frågor om personlig information: lösenord, PIN, inloggningskoder, personnummer...

- Dessa e-postmeddelanden innehåller ofta bilagor med dold skadlig programvara. Ladda aldrig ner dem!

- Lita aldrig på kampanjerbjudanden som ser "för bra för att vara sant"

Ett systematiskt cybersäkerhetsarbete är en strategisk fråga och är ett måste för alla företag

Ett viktigt tips från Addera

- Ett systematiskt cybersäkerhetsarbete är en strategisk fråga och är ett måste för alla företag, menar Adderas VD Jens Hemström och fortsätter, man kan säga att cybertrygghet är en grundläggande förutsättning för framgångsrikt företagande.

Företagsledningen bör alltid skapa sig en bra överblick över sina risker och sårbarheter, från vilka man skapar en tydlig prioriteringslista och åtgärdsplan. Adderas Cybersäkerhetsrapport ger en superb utgångspunkt för ett systematiskt säkerhetsarbete:

- Skapar en förståelse och nulägesbeskrivning

- Förtydligar säkerhetsbrister och riskområden

- Presenterar en tydlig åtgärdsplan och prioriteringslista för ökad cybersäkerhet

Dessutom ökar arbetet med Cybersäkerhetsrapporten företagsledningens och företagets kunskap om cyberhoten, risker och cybersäkerhetsarbete.

Bara det är ett stort steg på vägen!

Så till er företagare som inte tagit tag i er cybersäkerhet - låt cybersäkerhetsmånaden vara den inspiration som behövs för att sätta igång. Vi finns här när du behöver hjälp!

Dålig datahygien ökar riskerna med AI

Överallt finns exempel på hur Generativ AI blir en naturlig del både av arbetslivet och privatlivet. Fördelarna lyfts fram men ständigt framförs även en växande oro för felanvändning, vilket kan resultera till oavsiktlig spridning av känslig information.

Vi har tidigare sett cybersäkerhetsrapporter som hävdar att felaktigt använd AI är en av 2025-års stora risker, speciellt kopplat till att företagets personal delar konfidentiell information med AI-verktyg. Nu lyfts nya och allvarliga farhågor fram när AI-verktyg börjar användas på ostrukturerad, mångduplicerad och inaktuell företagsdata som ingen egentligen har kontroll på eller känner ägandeskap för.

Information läggs på hög och vår lagrade information bara växer och växer

Problemet med ostrukturerad information

Många företag känner nog igen sig i problemet med undermålig datahygien. Vi skapar massvis av ny data och information men organiserar inte och tar inte bort den gamla som har blivit inaktuell. Information läggs på hög och vår lagrade information bara växer och växer.

Lägg till nästa problem, där data återanvänds och dupliceras av användarna som dessutom delar med sig av nya sina filer och dokument, som innehåller data som på ett eller annat sätt redan finns lagrat. Delning av filer görs tyvärr ofta utan eftertanke vilket dels innebär att företagets information dels riskerar att bli ännu mer ostrukturerad och dels spridas vidare utan begränsning.

Som om det inte vore nog så händer det ju ganska ofta att personer slutar och lämnar sina jobb. Det enklaste åtgärden är att göra dessa användarkonto vilande, vilket leder till att delade filer och information blir ”föräldrarlösa” och utan informationsägare.

Hur mycket av er information saknar en ansvarig ägare?

Använda generativ AI på ostrukturerad information

Att använda intern information till sitt eget AI-verktyg har länge predikats som en lösning på de tidigt identifierade riskerna med AI och spridning av känslig information. En nyligen publicerad rapport visar dock att när informationen inte har rätt kvalitet, tex ostrukturerad och mångduplicerad, så ökar säkerhetskomplexiteten avsevärt vid användning av AI. Man måste således utvärdera och förstå riskerna för att känslig data därför används och sprids utan tillräcklig kontroll.

Ytterligare risker pga skugganvändning av AI

Lägg därtill den till synes utbredda skugganvändningen av AI, som är en risk som hamnar helt utanför verksamhetens kontroll. Rapporter visar nämligen att många yrkesverksamma använder AI-verktyg på jobbet som inte är godkända av företaget som man arbetar på. Användningen sker genom privata konton på osanktionerade verktyg och verksamheten vet i dessa fall varken hur omfattande användningen av AI är eller var förtagets känsliga information tar vägen.

Stor risk att känslig data används och sprids utan tillräcklig kontroll

Struktur och processer – kanske tråkigt men absolut nödvändigt

Som vi tidigare rekommenderat är det, från ett data- och informationssäkerhetshänseende, nödvändigt att både skaffa sig och bibehålla kontroll över sin information. Detta accentueras när AI blir en del av bilden.

En tydlig struktur behövs, som innefattar riktlinjer för tex användning, lagring och delning men också som också tydliga processer och informationsägande. Det är essentiellt att förtydliga ägandeskap och ansvar för företagets olika data och information samt att även löpande kartlägga vem som har tillgång till den.

Utbildning ökar medvetenheten

Strukturerad informationshantering är essentiell och med ökade risker kopplat till användning av AI så behöver alla företag vara tydliga i sina riktlinjer. Med tydliga policys och återkommande utbildning av personalen kan man minska sina risker genom att skapa den nödvändiga kulturen för en ansvarsfull informationshantering och användning av AI genom hela företaget.

Hur kan vi hjälpa er företagsledning med att ta nästa steg?

Cybersäkerheten måste utvecklas snabbare än AI

Användningen av AI ökar kraftigt då det för många fortfarande är en förhållandevis ny företeelse. Det stora genombrottet kom först när generativ AI gjordes tillgänglig på bred front och nu verkar det som att alla vill vara med i AI-racet.

Användningsområdena ökar också snabbt och generativ AI implementeras på otaliga ställen i våra verksamheter, från kundtjänstchattrobotar till marknadsföringskampanjer. Med ökad effektivitet och utveckling av AI kommer tyvärr också nya säkerhetsrisker. Många företag upptäcker att de varken är medvetna om eller förberedda för de säkerhetsutmaningar som AI skapar.

I en nyligen publicerad rapport, där flera tusen IT- och säkerhetsexperter har svarat på frågor, framkommer det tydligt att användningen av AI ställer nya krav på företagens säkerhetsprioriteringar.

Hög användning av AI och det ökar snabbt

En tredjedel av företagen i undersökningen har idag integrerat generativ AI i sin verksamhet samt har nått den punkt där den förändrar deras affärsprocesser. Denna förändring sker snabbt. Tyvärr rör sig många organisationer snabbt framåt med sina AI-projekt utan att varken förstå hur cyber- och informationssäkerheten påverkas av den snabba utvecklingen eller hur säkerheten ska kunna tryggas.

I rapporten svarade nästan 70 % av respondenterna att det snabbt föränderliga ekosystemet för generativ AI är deras största säkerhetsbekymmer. Komplexiteten och svårighet att överblicka säkerhetsriskerna är svårt och det som nämns är både AI-baserade SaaS-tjänster och alltmer autonoma AI-agenter som hanterar känslig data.

Snabba förändringar inom generativ AI är det största säkerhetsbekymret

Därtill finns mycket stor oro för att cyberbrottslingar fokuserar på att manipulera den data som AI-verktygen arbetar med. Denna risk rankas som mycket allvarlig och det kan sannolikt bero både på den potentiella skada som föreligger när AI-verktyg, speciellt autonoma, matas med medvetet manipulerad data men förmodligen också då detta är svårt att upptäcka.

Cybersäkerhet är en grundläggande framgångsfaktor för AI

Generativ AI är beroende av stora mängder data och information. Det är naturligtvis fördelaktigt när informationen är av hög kvalitet men framför allt måste informationen såklart vara tillförlitlig. Om den minsta osäkerhet finns gällande tillförlitlighet så faller trovärdigheten av AI-verktygets output vilket skulle äventyra de positiva effekter som AI är implementerade för att bidra med

Risk för manipulation av data som AI-verktygen arbetar med

Generativ AI kommer att fortsätta växa, och mycket av dess värde beror på kvaliteten och skyddet av den information som AI-verktygen använder som input. Cyber- och informationssäkerhet måste därför vara väldigt högt prioriterade, både för att kunna stå emot det allmänna cyberhotet, och för att säkerställa företags förmåga att dra nytta av alla fördelar med AI.

Policys och utbildning för en ansvarsfull användning av AI

Med ökade risker kopplat till användning av AI så behöver alla företag vara tydliga i sina riktlinjer gällande användning av AI. Med tydliga policys och återkommande utbildning av personalen kan man minska sina risker genom att skapa den nödvändiga kulturen för en ansvarsfull användning av AI genom hela företaget.

Företagsledningen måste leda arbetet och dessutom föregå med gott exempel!

Hör av dig så hjälper vi er att skapa både en större motståndskraft och en ökad cybertrygghet!

Tre sekunder ljud räcker för att AI-klona din röst!

I en cybersäkerhetsartikel konstateras att det räcker med en tre sekunder lång ljudupptagning för att cyberkriminella ska kunna klona en persons röst. En så kort ljudsnutt skulle kunna hämtas från ett videoklipp som delas på sociala medier eller kopieras från ditt svarsmeddelande på din voicemail.

Röstkapning genom AI-kloning: kan du lita på dina öron?

Många tror sig säkert kunna känna igen en AI-klonad röst. Tyvärr verkar det som att man inte ska känna sig alltför säker på den saken.

Ett exempel som nämns är en amerikansk mamma som nästan blev offer för ett virtuellt kidnappningsbedrägeri, där en klonad röst på ett övertygande sätt härmade hennes dotters rop på hjälp. Ett hänsynslöshet exempel på AI-bedrägeri, där en form av social manipulation tar sig den fulaste formen.

Social manipulation av den fulaste formen

Växande hot mot företag

Bedrägerier med röstkapning genom AI har hittills mest inriktat sig mot privatpersoner, speciellt mot de äldre, där bedrägerier görs genom att man imiterat familjemedlemmar. Trenden är dock att AI-klonade röstbedrägerier är ett växande hot även mot företag.

En anställd på ekonomiavdelningen kan falla offer för ett samtal som denne tror kommer från VD:n, särskilt eftersom dessa typer av bedrägerier typiskt görs genom att skapa en känsla av auktoritet och brådska så att behovet av att agera snabbt blir viktigt.

Bedrägerier med generativ AI, kan innebära förluster på 40 miljarder dollar

Ett aktuellt exempel, från tidigare i år, hände i Italien där en framstående affärsman blev lurad i en deepfake där man AI-klonat försvarsministerns röst som bad om pengar för snabb hjälp att befria kidnappade journalister. Affärsmannen förde över 1 miljon euro men då bedrägeriet upptäcktes i tid kunde polisen spärra kontot och pengarna återtas.

Även om dessa typer av exempel finns så kan man tycka att det känns orimligt att så väldigt många ska kunna bli lurade och i stor skala. Studier från USA förutspår dock att detta och andra bedrägerier med generativ AI, kan innebära att företag i USA förlorar upp mot 40 miljarder dollar fram till 2027.

Biometrisk röstautentisering räcker inte

Aktörer inom den finansiella sektorn har använt röstbiometri ett tag för att identifiera kunder som tex kontaktar deras kundtjänst. Nu finns indikationer på att även denna metod blir omsprungen av AI-klonade röster. För att ligga i framkant behöver man sannolikt kombinera röstautentisering med en integrerad multifaktorsautentisering.

Kombinera röstautentisering med integrerad MFA

Framtidens och nutidens skydd mot AI-klonad röstkapning

Teknik

Det behövs mer avancerad röstautentiseringsteknik som kontrollerar fler aspekter av en persons röst, som ton och rytm. Att bara utgå från röstkaraktär räcker snart inte längre.

Om man dessutom kombinerar röstigenkänning med beteendeanalys, som tittar på talmönster som pauser, tonskiften och stress, ökar svårighetsgraden för AI-kloning. Vi har alla subtila variationer som är ytterst svåra för AI att efterlikna.

Beteende

I en tid av sociala medier kan det kanske kännas svårt för många att begränsa mängden personlig information som delas online, speciellt ljud- och videoklipp. Men då brottslingar kan använda dessa källor för att klona både röst och bild för att utföra bedrägerier och deepfake så vore det nog klokt att försöka vara mer restriktiva.

Dock är ett av de kraftfullaste verktygen för att bygga motståndskraft klart inom räckhåll. Att utbilda er personal på ett bra sätt ökar medvetenheten gällande både förekomsten av bedrägerier och social manipulation och att vara uppmärksam på just AI-driven deepfake och röstkloning. Att personalen är medveten om, och förstår hur bedragare kan använda AI för att replikera röster i syfte att luras och manipulera, gör att man lättare får dem att ifrågasätta alla ovanliga förfrågningar, särskilt de som rör pengar eller känslig information.

Hör av dig så hjälper vi er att skapa både en större motståndskraft och en ökad cybertrygghet!

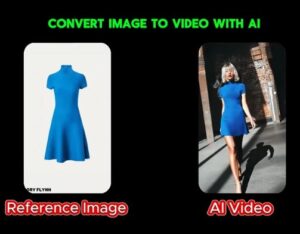

Falsk AI-plattform skickar virus istället för video

Nu sprids nyheter om ett nytt cyberhot kopplat till AI, nämligen fake-AI, där användare presenteras med ett verktyg som för generativ AI som kan skapa en video av en bild. Men istället för en videofil så laddar användaren ner skadlig programvara.

Välkänd risk för dataläckage genom felaktigt använd AI

När vi tydligt ser hur AI blir en naturlig del både av arbetslivet och privatlivet, finns ett växande oro för felanvändning, vilket kan resultera till oavsiktlig spridning av känslig information.

I en cybersäkerhetsrapport ses felaktigt använd AI som en av 2025-års stora risker. Det tydligaste riskområdet är dataläckage och händer när företagets personal delar konfidentiell information, med AI-verktyg för att skapa rapporter och göra analyser, utan att vara medveten om att någon obehörig kan få tillgång till och lagra den känsliga informationen.

Felaktigt använd AI ses som en av 2025-års stora risker

Ny risk med fake-AI: ett finurligt lurendrejeri som ny attackmetod

Då vi ser att användning av AI-verktyg blir vardagsmat för många så använder sig millioner människor dagligen av AI för att skapa innehåll. Detta ger nu cyberkriminella en möjlighet att lansera en ny, och extremt finurlig, attackmetod, fake-AI.

Ett aktuellt exempel som marknadsförs genom annonser på vanliga sociala medier, tex Meta, erbjuder en fantastiskt spännande och tillsynes legitim AI-tjänst för att generera video från bild. Man uppmanas att ladda upp tex en bild, under intrycket att de använder riktig AI, för att generera ett filmklipp där bilden används.

Exempel på annons

Laddar ner skadligt program istället för film

När filmen ”skapats av AI-verktyget” instrueras användarna att ladda ner sin genererade film. Tyvärr laddar offren då omedvetet ned en skadlig programvara som ser ut som en mediafil. I en ZIP-fil (arkiv) finns en fil i ett förväntat filformat, tex .mp4 men som i själva verket är en infostealer eller annan skadlig programvara som då installeras av användaren när denne tror sig öppna sitt AI-genererade filmklipp.

Med den skadliga programvaran installerad kan hackaren stjäla känslig information eller fjärrstyra datorn för att åstadkomma annan skada i IT-systemet.

Kommer säker fler varianter

I den här specifika kampanjen känns det skadliga AI-verktyget igen under namn typ VideoDreamMachine, men nya falska verktyg kommer sannolikt att dyka upp, utöver andra liknande kampanjer/tjänster som redan kan vara lanserade...

Policys och utbildning för en ansvarsfull användning av AI

Med ökade risker kopplat till användning av AI så behöver alla företag vara tydliga i sina riktlinjer gällande användning av AI. Med tydliga policys och återkommande utbildning av personalen kan man minska sina risker genom att skapa den nödvändiga kulturen för en ansvarsfull användning av AI genom hela företaget.

Företagsledningen måste leda arbetet och dessutom föregå med gott exempel!

Attacker med deepfake ökar explosionsartat

Från att ha varit en obetydlig del och mest en oro för framtiden är nu deepfake-attacker ett snabbt växande hot. Måltavlan har främst varit den finansiella marknaden, där det rapporteras om en explosionsartad ökning, vilket gör att det finns all anledning att misstänka att deepfakes snart kommer att användas i stor utsträckning även mot andra branscher.

Deepfake

Det har talats om att vi i framtiden riskerar att mötas av AI-genererade bedrägerier där telefonsamtal och t.o.m. videokonferenser skulle kunna lura personer att tro att de talar med sin chef eller kollega. Rösten är den rätta, informationen är korrekt och t.o.m. privata ämnen tas upp under samtalet. Tyvärr beskrivs det i rapporter och artiklar att deepfakes inte är ett framtida hot utan används i stor utsträckning redan idag - och dessutom ökar kraftigt.

Deepfake tar social manipulation till nästa nivå

Attackmetod

Man kan beskriva deepfake som ett sätt att imitera en person, ner till väldigt små detaljer, för att manipulera och övertyga en annan person eller kollega att utföra en viss handling. Det kan vara att föra över pengar eller skaffa sig tillgång till hemlig information.

Avancerad och AI-driven teknologi är grunden för att skapa deepfakes och tekniken är nu så kraftfull att cyberkriminella kan lyckas med dessa imitationer och deepfakes även i realtid, dvs videokonferenser.

Finansiellt bedrägeri

Det mest kända stora finansiella deepfake-bedrägeriet är nog det där bedragarna lyckades stjäla motsvarande 250 miljoner kronor från ett bolag i Hong Kong. En medarbetare fick ett mejl från bolagets finanschef i Storbritannien som informerade om att en hemlig penningtransaktion behövde genomföras. Medarbetaren fattade dock misstankar men efter ett videomöte där finanschefen och andra medarbetare deltog kände medarbetaren sig övertygad och genomförde transaktionen. I videomötet såg och lät kollegorna nämligen precis som vanligt.

Informationsstöld

En annan typ av deepfake-bedrägerier som fått uppmärksamhet är när företag anställer på distans, vilket typiskt handlar om konsulter som kan erbjuda kompetens inom ett visst område. Scenariot involverar en stulen Linkedinprofil, ett CV som matchar och en distansintervju som är deepfake, vilket resulterar i en anställning som handlar om att infiltrera och stjäla information.

Ett omtalat fall i denna kategori är ett amerikanskt företag som anställde en person som utgav sig för att vara någon helt annan och med hjälp av deepfake lyckades bli anställd. Personen i fråga var egentligen nordkorean och hade, vid upptäckt, redan installerat skadlig kod i företagets system.

Kravet för ökad motståndskraft: utbildning som både ger tydliga rutiner och en säkerhetskultur

Utbildning av personalen för att öka medvetenheten om social manipulation och om deepfake är ett sätt att öka motståndskraften. Tydliga rutiner, instruktioner och processer är också mycket verkningsfullt men om man inte skapar en säkerhetskultur som får personalen att vilja följa rutinerna så blir de verkningslösa tomma ord.

Hör av dig så hjälper vi er!